早期观测值对预测所有未来观测值具有非常重要的意义。我们希望由某些机制能够在一个记忆元里存储重要的早期信息,如果没有这样的机制,我们将不得不给这个观测值指定一个非常大的梯度,因为它会影响所有后续的观测值。

一些词元没有相关的观测值。我们希望有一些机制来跳过隐状态表示中的此类词元,

序列的各个部分之间存在逻辑上的中断。在这种情况下,最后有一种方法来重置内部状态的表示。

为解决这些问题,最早的方法是长短期记忆网络(LSTM),门控循环单元(GRU)是一个稍微简化的变体,通常能够提供同等的效果,并且计算的速度明显变快。

我们首先介绍更简单的门控循环单元。

门控循环单元与普通的神经网络之间的关键区别在于:前者支持隐状态的门控。

这意味着模型有专门的机制来确定应该何时更新隐状态,以及应该何时重置隐状态。

重置门允许我们控制“可能还想记住”的过去状态的数量

更新门允许我们控制新状态中有多少个旧状态的副本

对于门控循环单元中的重置门和更新门:

输入由当前时间步的输入和前一个时间步的隐状态给出

输出由使用带有sigmoid激活函数的两个全连接层给出

对于给定的时间步t t t X t ∈ R n × d X_t\in R^{n\times d} X t ∈ R n × d H t − 1 ∈ R n × h H_{t-1}\in R^{n\times h} H t − 1 ∈ R n × h n n n d d d h ) h) h )

那么,重置门R t ∈ R n × h R_t \in R^{n\times h} R t ∈ R n × h Z t ∈ R n × h Z_t\in R^{n\times h} Z t ∈ R n × h

R t = σ ( X t W x r + H t − 1 W h r + b r ) Z t = σ ( X t W x z + H t − 1 W h z + b z ) R_t = \sigma(X_tW_{xr}+H_{t-1}W_{hr}+b_r) \\

Z_t = \sigma(X_tW_{xz}+H_{t-1}W_{hz}+b_z)

R t = σ ( X t W x r + H t − 1 W h r + b r ) Z t = σ ( X t W x z + H t − 1 W h z + b z )

接下来,将重置门R t R_t R t t t t H ~ t ∈ R n × h \widetilde H_t\in R^{n\times h} H t ∈ R n × h

H ~ t = t a n h ( X t W x h + ( R t ⊙ H t − 1 ) W h h + b h ) \widetilde{H}_t = tanh(X_tW_{xh}+(R_t\odot H_{t-1})W_{hh}+b_h)

H t = t a n h ( X t W x h + ( R t ⊙ H t − 1 ) W h h + b h )

其中,W x h ∈ R d × h W_{xh}\in R^{d\times h} W x h ∈ R d × h W h h ∈ R h × h W_{hh}\in R^{h\times h} W h h ∈ R h × h b h ∈ R 1 × h b_h\in R^{1\times h} b h ∈ R 1 × h ⊙ \odot ⊙

与传统的隐状态相比,R t R_t R t H t − 1 H_{t-1} H t − 1

当重置门R t R_t R t

当重置门R t R_t R t X t X_t X t

上述计算结果只是候选隐状态,我们仍然需要结合更新门Z t Z_t Z t

这一步确定新的隐状态H t ∈ R n × h H_t\in R^{n\times h} H t ∈ R n × h H t − 1 H_{t-1} H t − 1 H ~ t \widetilde{H}_t H t

更新门Z t Z_t Z t H t − 1 H_{t-1} H t − 1 H ~ t \widetilde{H}_t H t

门控循环单元的最终公式为:

H t = Z t ⊙ H t − 1 + ( 1 − Z t ) ⊙ H ~ t H_t = Z_t\odot H_{t-1} + (1-Z_t)\odot \widetilde{H}_t

H t = Z t ⊙ H t − 1 + ( 1 − Z t ) ⊙ H t

当更新门Z t Z_t Z t X t X_t X t t t t

相反,当Z t Z_t Z t H t H_t H t H ~ t \widetilde{H}_t H t

这些设计可以处理循环神经网络中的梯度消失问题,并更好地捕获时间步很长的序列的依赖关系。

重置门有助于捕获序列中的短期依赖关系

更新们有助于捕获序列中的长期依赖关系

读取数据集:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 import torch

我们从标准差为0.01的高斯分布中提取权重,并将偏置设为0,超参数num_hiddens定义隐藏单元的数量,实例化与更新门、重置门,候选隐状态和输出层相关的所有权重和偏置。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 def get_params(vocab_size, num_hiddens, device):

定义隐状态的初始化函数init_gru_state,此函数返回一个形状为(批量大小,隐藏单元数)的张量,张量的值全部为0.

1 2 def init_gru_state(batch_size, num_hiddens, device):

接下来定义门控循环单元模型,模型的结构与基本的循环神经网络单元是相同的,只是权重更新公式更复杂。

1 2 3 4 5 6 7 8 9 10 11 12 13 def gru(inputs, state, params):

创建模型

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 class RNNModelScratch:

训练过程与之前完全一致:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 import math

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 '''省略迭代器、词表的获取'''

长期以来,隐变量模型存在着长期信息保存和短期输入缺失的问题。

解决这一问题的最早方法之一是长短期记忆网络。

长短期记忆网络引入了记忆元,或简称为单元。

为了控制记忆元,我们需要许多门:

输出门:从记忆元中输出条目

输入门:决定何时将数据读入记忆元

遗忘门:重置记忆元的内容。

当前时间步的输入和前一个时间步的隐状态作为数据输入长短期记忆网络的门中,由3个带有sigmoid激活函数的全连接层处理,以计算输入门、遗忘门和输出门的值。

假设有h h h n n n d d d X ∈ R n × d X\in R^{n\times d} X ∈ R n × d H t − 1 ∈ R n × h H_{t-1}\in R^{n\times h} H t − 1 ∈ R n × h

时间步t t t

输 入 门 : I t = σ ( X t W x i + H t − 1 W h i + b i ) 遗 忘 门 : F t = σ ( X t W x f + H t − 1 W h f + b f ) 输 入 门 : O t = σ ( X t W x o + H t − 1 W h o + b o ) 输入门:I_t = \sigma(X_tW_{xi}+H_{t-1}W_{hi}+b_i)\\

遗忘门:F_t = \sigma(X_tW_{xf}+H_{t-1}W_{hf}+b_f)\\

输入门:O_t = \sigma(X_tW_{xo}+H_{t-1}W_{ho}+b_o)

输 入 门 : I t = σ ( X t W x i + H t − 1 W h i + b i ) 遗 忘 门 : F t = σ ( X t W x f + H t − 1 W h f + b f ) 输 入 门 : O t = σ ( X t W x o + H t − 1 W h o + b o )

因为还没有指定各种门的操作,所以先介绍候选记忆元C ~ t ∈ R n × h \widetilde{C}_t\in R^{n\times h} C t ∈ R n × h

C ~ t = t a n h ( X t W x c + H t − 1 W h c + b c ) \widetilde{C}_t=tanh(X_tW_{xc}+H_{t-1}W_{hc}+b_c)

C t = t a n h ( X t W x c + H t − 1 W h c + b c )

在GRU中,有一种机制来控制输入和遗忘,类似地,在长短期记忆网络中,也有两个门用于这样的目的:输入门I t I_t I t C ~ t \widetilde{C}_t C t F t F_t F t C t − 1 ∈ R n × h C_{t-1}\in R^{n\times h} C t − 1 ∈ R n × h

即:

C t = I t ⊙ C ~ t + F t ⊙ C t − 1 C_t = I_t\odot\widetilde{C}_t + F_t\odot C_{t-1}

C t = I t ⊙ C t + F t ⊙ C t − 1

H t = O t ⊙ t a n h ( C t ) H_t = O_t\odot tanh(C_t)

H t = O t ⊙ t a n h ( C t )

1 2 3 4 5 6 import torch

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 def get_lstm_params(vocab_size, num_hiddens, device):

在初始化函数中,长短期记忆网络的隐状态需要返回一个额外的记忆元,其值为0,形状为(批量大小,隐藏单元数)。

1 2 3 4 5 def init_lstm_state(batch_size, num_hiddens, device):

实际模型的定义与前文讨论一致,需要注意的是只有隐状态才会传递到输出层,而记忆元不会直接参与输出。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 def lstm(inputs, state, params):

构建网络:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 vocab_size, num_hiddens, device = len(vocab), 256, 'cuda:0'

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 import math

使用高级API,我们可以直接实例化长短期记忆网络模型。

1 2 3 4 num_inputs = vocab_size

我们可以将深度结构中的函数关系形式化。

假设在时间步t t t X t ∈ R n × d X_t\in R^{n\times d} X t ∈ R n × d l l l H t ( l ) ∈ R n × h H_t^{(l)}\in R^{n\times h} H t ( l ) ∈ R n × h O t ∈ R n × h O_t\in R^{n\times h} O t ∈ R n × h H t ( 0 ) = X t H_t^{(0)} = X_t H t ( 0 ) = X t l l l ϕ l \phi_l ϕ l

H t ( l ) = ϕ l ( H t ( l ) W x h ( l ) + H t − 1 ( l ) W h h ( l ) + b h ( l ) ) H_t^{(l)} = \phi_l(H_t^{(l)}W_{xh}^{(l)}+H_{t-1}^{(l)}W_{hh}^{(l)}+b_h^{(l)})

H t ( l ) = ϕ l ( H t ( l ) W x h ( l ) + H t − 1 ( l ) W h h ( l ) + b h ( l ) )

最后,输出层的计算仅基于第l l l

O t = H t ( L ) W h q + b q O_t = H_t^{(L)}W_{hq}+b_q

O t = H t ( L ) W h q + b q

与MLP意义,隐藏层数L L L h h h

另外,用门控循环单元或长短期记忆网络的隐状态来代替上式的隐状态,可以得到深度门控循环神经网络或深度长短期记忆神经网络。

以LSTM为例,构建lstm_layer与之前相似,设定输入、隐藏单元数以外,还需设置隐藏层数。

1 lstm_layer = nn.LSTM(num_inputs, num_hiddens, num_layers)

在序列学习中,我们以往假定的目标是:在给定观测的情况下,对下一个输出进行建模。

虽然这是一个经典场景,但不是唯一的。例如填空题。

如果希望在循环神经网络中拥有一种机制,使之能够提供与隐马尔可夫模型类似的前瞻能力,我们就需修改循环神经网络的设计。

增加一个从最后一个词元开始从后向前运行的循环神经网络。

双向循环的神经网络添加了反向传递信息的隐藏层,以便更灵活地处理此类信息。

对于任意时间步t t t X t ∈ R n × d X_t\in R^{n\times d} X t ∈ R n × d ϕ \phi ϕ

在双向架构中,我们设该时间步的前向隐状态和反向隐状态分别为:

H t → = ϕ ( X t W x h ( f ) + H t − 1 → W h h ( f ) + b h ( f ) ) H t ← = ϕ ( X t W x h ( b ) + H t − 1 ← W h h ( b ) + b h ( b ) ) H^{\rightarrow}_t=\phi(X_tW_{xh}^{(f)}+H^{\rightarrow}_{t-1}W_{hh}^{(f)}+b_h^{(f)})\\

H^{\leftarrow}_t=\phi(X_tW_{xh}^{(b)}+H^\leftarrow_{t-1}W_{hh}^{(b)}+b_h^{(b)})

H t → = ϕ ( X t W x h ( f ) + H t − 1 → W h h ( f ) + b h ( f ) ) H t ← = ϕ ( X t W x h ( b ) + H t − 1 ← W h h ( b ) + b h ( b ) )

接下来,将前向隐状态和反向隐状态连接起来,获得送入输出层的隐状态H t H_t H t

在具有多个隐藏层的深度双向循环神经网络中,该信息作为输入传递到下一个双向层。

最后输出层计算得到的输出为O t ∈ R n × q O_t\in R^{n\times q} O t ∈ R n × q

双向循环神经网络的一个关键特性是:使用来自序列两端的信息来估计输出。

我们使用来自过去和未来的观测信息来预测当前的观测。但是对于下一个词元进行预测的去块,这样的模型并不是我们所需的,因为在预测下一个词元时,我们终究无法知道下一个词元的下文是什么,所以将不会得到很高的精度。

具体地说,在训练期间,我们能够利用过去和未来的数据来估计当前空缺的词,在测试期间我们只有过去的数据,因此精确度将会很低。

还有一个严重的问题是,双向循环神经网络的计算速度非常慢。其主要原因是网络的前向传播需要在双向层中进行前向递归和后向递归。

双向层的使用在实践中非常少,并且仅应用于部分场景。

语言模型是自然语言处理的关键,而机器翻译是语言模型最成功的基准测试,因为机器翻译正是将输入序列转换成输出序列的序列转换模型的核心问题。

1 2 3 import os

下载“英语-法语”数据集,数据集中的每一行都是制表符。

其中英语是源语言,法语是目标语言。

1 2 3 4 5 6 7 8 9 d2l.DATA_HUB['fra-eng'] = (d2l.DATA_URL+'fra-eng.zip','94646ad1522d915e7b0f9296181140edcf86a4f5')

下载数据集后,原始文本数据需要经过几个预处理步骤。例如,用空格代替不间断空格,用小写字母代替大写字母,并在单词和标点符号之间插入空格。

1 2 3 4 5 6 7 8 9 10 11 12 def preprocess_nmt(text):

在机器翻译中,我们倾向于使用单词级词元化。

实现tokenize_nmt函数,对前num_examples个文本序列对进行词元,其中每个词元要么是一个词,要么是一个标点符号。

此函数返回两个词元列表:source和target。source[i]是源语言第i i i

1 2 3 4 5 6 7 8 9 10 11 12 13 def tokenize_nmt(text, num_examples=None):

由于机器翻译数据集由语言对组成,因此我们可以分别为源语言和目标语言构建两个词表。

使用单词级词元化时,词表大小将明显大于使用字符级词元化时的词表大小。

为了缓解这个问题,这里我们将出现次数少于2的低频次元视为相同的未知词元。

持此之外,还指定了额外的特定词元,例如在小批量时用于将序列填充到相同长度的填充词元,以及序列的开始词元和结束词元。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 import collections

语言模型的序列样本都有一个固定的长度,这个固定片段是由时间步数决定的。

在机器翻译中,每个样本都是由源和目标组成的文本序列对,其中的每个文本序列可能具有不同的长度。

为了提高计算效率,我们仍然可以通过截断和填充方式实现一次只处理一个小批量的文本序列。

假设同一个小批量中的每个序列都应该具有相同的长度num_steps,那么如果文本序列的词元数少于num_steps,我们将在末尾添加特定的’<pad>'词元,直到其长度为num_steps;反之,截断文本序列。

1 2 3 4 5 6 def truncate_pad(line, num_steps, padding_token):

接下来定义一个可以将文本序列转换成小批量数据集用于训练的函数。

我们将特定的’<eos>‘词元添加到所有序列的末尾,用于表示序列的结束。当模型通过一个词元接一个词元地生成序列进行预测时,生成的’<eos>'词元说明完成了序列输出工作。

此外,我们还记录了每个文本序列的长度,统计长度时剔除了填充词元。

1 2 3 4 5 6 def build_array_nmt(lines, vocab, num_steps):

定义load_data_nmt函数来返回数据迭代器,以及源语言和目标语言的两种词表.

1 2 3 4 5 6 7 8 9 10 11 12 def load_data_nmt(batch_size, num_steps, num_examples=600):

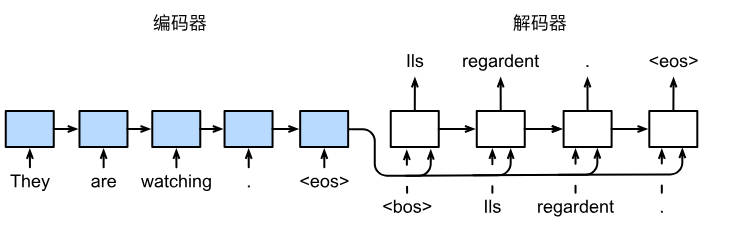

机器翻译是序列转换模型的一个核心问题,其输入和输出都是长度可变的序列。

为了处理这种类型的输入和输出,我们可以设计一个包含两个主要组件的架构。

第一个组件是一个编码器,接收一个长度可变的序列作为输入,并将其转换为固定形态的编码状态

第二个组件时解码器,将固定形状的编码状态映射到长度可变的序列。

这被称为编码器-解码器结构。

在编码器接口,我们只指定长度可变的序列作为编码器的输入X.

1 2 3 4 5 6 7 8 from torch import nn

在下面的解码器接口中,新增一个init_state函数,用于将编码器的输出转换为编码后的状态。

1 2 3 4 5 6 7 8 9 class Decoder(nn.Module):

总而言之,编码器-解码器结构包含了一个编码器和一个解码器,并且还拥有可选的额外参数。

在前向传播过程中,编码器的输出用于生成编码状态,这个状态又被解码器作为其输入的一部分。

1 2 3 4 5 6 7 8 9 10 class EncoderDecoder(nn.Module):

本节,我们将使用两个循环神经网络的编码器和解码器,并将其应用于序列到序列类的任务。

遵循编码器-解码器架构的设计原则,循环神经网络编码器使用长度可变的序列作为输入,将其转换为固定形态的隐状态。

换言之,输入序列的信息被编码到循环神经网络编码器的隐状态中。

为了连续生成输出序列的词元,独立的循环神经网络解码器是基于输入序列的编码信息和输出序列可见的或者生成的词元来预测下一个词元。

1 2 3 4 5 import collections

从技术上讲,编码器将长度可变的输入序列转换成固定形状的上下文变量c c c

考虑由一个序列组成的样本,假设输入序列是x 1 , x 2 , … , x T x_1, x_2, \dots, x_T x 1 , x 2 , … , x T x t x_t x t t t t

在时间步t t t x t x_t x t x t x_t x t h t − 1 h_{t-1} h t − 1 h t h_t h t

h t = f ( x t , h t − 1 ) h_t = f(x_t, h_{t-1})

h t = f ( x t , h t − 1 )

总之,编码器通过选定的函数q q q

c = q ( h 1 , … , h T ) c = q(h_1, \dots, h_T)

c = q ( h 1 , … , h T )

到目前为止,使用的是一个单向循环神经网络来设计编码器,其中隐状态只依赖输入子序列,这个子序列为输入序列的开始位置到隐状态所在的时间步的位置(包含)。

我们也可以使用双向循环神经网络构建编码器,其中隐状态依赖两个输入子序列:

隐状态所在的时间步的位置之前的序列

隐状态所在的时间步的位置之后的序列(包含)

在循环神经网络的编码器实现中,将使用嵌入层来获得输入序列中每个词元的特征向量。

嵌入层的权重是一个矩阵,其行数等于输入词表的大小,其列数等于特征向量的维度。

对于任意输入词元的索引i i i i i i

另外,这里选择了一个多层门控循环单元来实现编码器。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 class Seq2SeqEncoder(Encoder):

计算过程分析:

使用一个两层门控循环单元编码器,其隐藏单元数为16.给定一个小批量的输入序列X,在完成所有时间步后,最后一层的隐状态是一个张量,其形状为(时间步数,批量大小,隐藏单元数);最后一个时间步的多层隐状态的形状为(隐藏层数,批量大小,隐藏单元数)。

1 2 3 4 5 6 7 8 encoder = Seq2SeqEncoder(10, 8, 16, 2)

正如上文所提到的,编码器输出的上下文变量c c c x 1 , … , x T x_1,\dots, x_T x 1 , … , x T

来自训练数据集的输出序列y 1 , y 2 , . . . , y T y_1, y_2, ..., y_T y 1 , y 2 , . . . , y T t ′ t' t ′ y t ′ y_{t'} y t ′ y 1 , y 2 , . . . , y t ′ − 1 y_1, y_2, ..., y_{t'-1} y 1 , y 2 , . . . , y t ′ − 1 c c c

为了在序列上模型化这种条件概率,我们可以使用另一个循环神经网络作为编码器。

在输出序列上的任意时间步t ′ t' t ′ y t ′ − 1 y_{t'-1} y t ′ − 1 c c c s t ′ − 1 s_{t'-1} s t ′ − 1 s t ′ s_{t'} s t ′

因此,可以使用函数g g g

s t ′ = g ( y t ′ − 1 , c , s t ′ − 1 ) s_{t'} = g(y_{t'-1}, c, s_{t'-1})

s t ′ = g ( y t ′ − 1 , c , s t ′ − 1 )

在获得解码器的隐状态之后,我们可以使用输出层和softmax操作来计算在时间步t ′ t' t ′ y t ′ y_{t'} y t ′ P ( y t ′ ∣ y 1 , … , y t ′ − 1 , c ) P(y_{t'}|y_1,\dots, y_{t'-1}, c) P ( y t ′ ∣ y 1 , … , y t ′ − 1 , c )

此处实现解码器时,我们直接使用编码器最后一个时间步的隐状态来初始化解码器的隐状态。

同时,为了进一步包含经过编码的输入序列的信息,上下文变量在所有的时间步与解码器的输入进行连接。

为了预测输出词元的概率分布,在循环神经网络解码器的最后一层使用全连接层来变换隐状态。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 class Seq2SeqDecoder(Decoder):

在每个时间步,解码器预测了输出词元的概率分布。类似于语言模型,可以使用softmax来获得分布,并通过计算交叉熵损失函数来进行优化。

但由于未来使不同长度的序列可以以相同形状的小批量加载,我们在序列末尾填充了特定词元。这一部分的填充词元的预测在损失函数的计算中剔除。

为此,我们可以使用下面的sequence_mask函数通过零值化屏蔽不相干的项,以便后面任何不相干的预测的计算都是与0相乘。

1 2 3 4 5 6 def sequence_mask(X, valid_len, value=0):

通过扩展softmax交叉熵损失函数来屏蔽不相关的预测。最初所有预测词元的掩码都设置为1.一旦给定了有效长度,与填充词元对于的掩码将被设置为0.最后,将所有词元的损失乘以掩码,以过滤掉损失中填充词元产生的不相干预测。

1 2 3 4 5 6 7 8 9 10 11 class MaskedSoftmaxCELoss(nn.CrossEntropyLoss):

在下面的循环训练过程中,特定的序列开始词元和原始的输出序列连接在一起作为解码器的输入。这被称为强制教学,因为原始的输出序列被送入解码器,或者将来自上一个时间步的预测得到的词元作为解码器的当前输入。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 def train_seq2seq(net, data_iter, lr, num_epochs, tgt_vocab, device):

训练参数如下:

1 2 3 4 5 6 7 8 9 embed_size, num_hiddens, num_layers, dropout = 32, 32, 2, 0.1

我们可以通过与真实的标签序列进行比较来评估预测序列。

原则上讲,对于预测序列中的任意n元语法,都可以使用BLEU评估这个n元语法是否出现在标签序列中。

BLEU定义如下:

e x p ( m i n ( 0 , 1 − l e n l a b e l l e n p r e d ) ) ∏ n = 1 k p n 1 / 2 n exp(min(0, 1-\frac{len_{label}}{len_{pred}}))\prod_{n=1}^kp_n^{1/2^n}

e x p ( m i n ( 0 , 1 − l e n p r e d l e n l a b e l ) ) n = 1 ∏ k p n 1 / 2 n

其中,l e n l a b e l len_{label} l e n l a b e l l e n p r e d len_{pred} l e n p r e d k k k n n n p n p_n p n n n n n n n n n n

1 2 3 4 5 6 7 8 9 10 11 12 13 14 def bleu(pred_seq, label_seq, k):

预测过程使用predict_seq2seq即可,略。